快速定位和解决接口延迟问题

接口延迟问题是应用中最常见的问题之一,且大多数都会对用户体验产生最直接甚至致命的影响。由于接口延迟问题可能受很多因素影响,很多故障都以这种形式出现在监控数据与用户体验侧,往往是最常见多发的业务问题,也是最难快速定位和处理的问题之一。

通过在线Demo)故障注入平台,注入例如

运行额外任务抢占Pod可用的CPU资源Pod丢包30%使方法抛出运行时异常增加处理每个请求的CPU消耗DNS请求延迟200ms等故障来模拟真实环境中因各种因素导致的接口延迟问题。

本指南将展示如何使用 Kindling-OriginX 对接口延迟问题进行快速定位与处置,并为后续工作提供有力数据支持,同时与传统方式进行简单对比。

传统方式

接口响应慢常常是多种故障的最终故障表征之一,传统方式其排查方式往往以资源领域的思路展开,常见的排查点和方法包括以下几点。

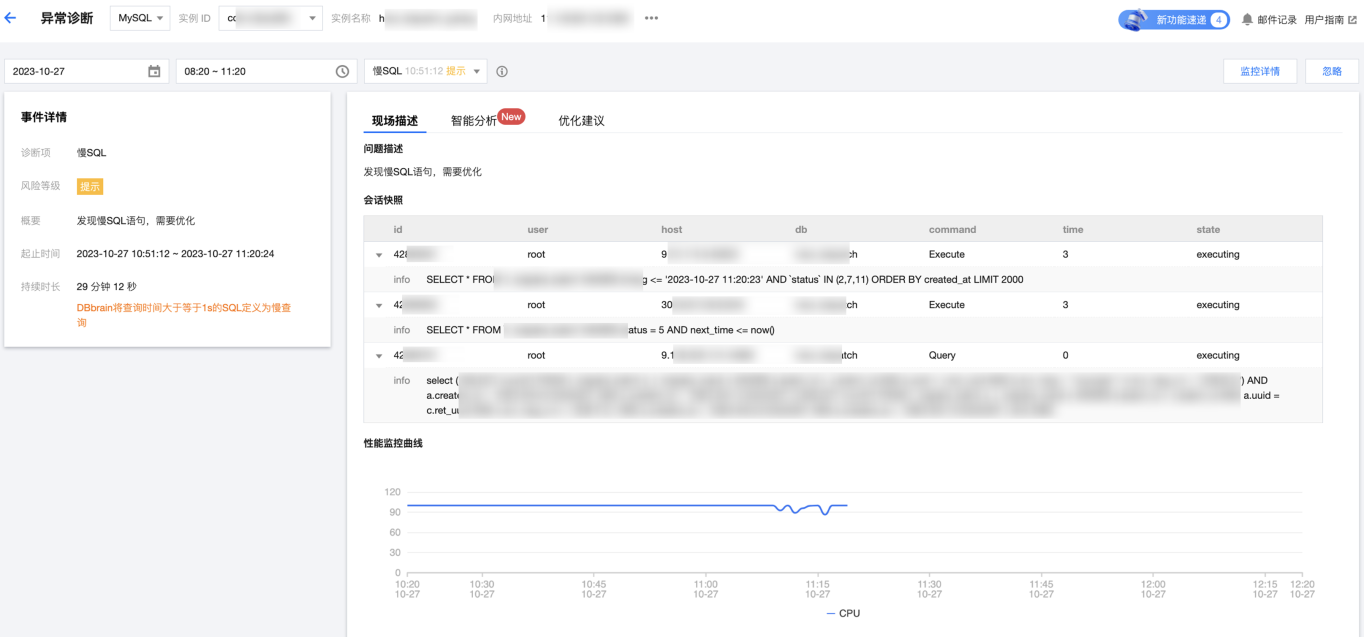

数据库

检查数据库连接是否正常,可能是连接池配置不合理、数据库连接数过多等原因导致。借助相应监控或数据库诊断工具查看数据库响应时延是否正常。例如目前多数云服务厂商提供DB在线诊断功能,可以通过DB诊断判断是否因为数据库原,但实际情况下,极有可能成为根因的噪声数据,误导排查方向。

代码逻辑

检查接口的代码是否有性能瓶颈或潜在的问题。通过添加日志、性能监控工具等方式,查找定位具体哪一部分代码耗时较长。这种方式需要对代码及业务架构足够熟悉,且需要多方数据汇总分析,难以做到快速高效定位。

并发问题

接口的响应时间和并发性能,确认是否因为如果并发访问导致接口响应慢。以Skywalking为例,主要通过入口流量变化、负载数据及其他APM数据判断是否是高并发导致性能问题,实际情况下以采取先扩容的方式为主,没法定位到问题根因。

网络延迟

利用ping命令等测试网络连通性,查看是否出现网络延迟或丢包现象。大多数团队缺乏网络方面专家,同时受服务商、基础设施情况影响大,很多情况下无法展开快速有效排查。

硬件资源

检查CPU、内存、磁盘等资源是否满负荷运行,是否因资源问题导致。通过监控工具走查硬件相关指标,根据经验对问题方向进行判断,对监控能力、专家经验和团队综合能力要求高,往往靠猜测判断。

排查接口响应慢的原因需要综合考虑网络、数据库、代码逻辑、依赖服务、并发和硬件资源等多个方面,并且需要使用合适的工具和方法进行监测和分析,定位到具体的问题所在。实际生产环境中受多种因素影响,更无法做到快速有效定位及查找故障根因,同时这类问题直接对用户体验造成巨大影响,更迫切需要有效的工具和方法能够进行应对。

使用Kindling-OriginX

Kindling-OriginX 对于接口延迟问题提供自动化、零侵入、高效便捷、极低性能损耗的解决方案,对故障进行快速有效的定位,同时给出可解释的故障根因报告。

针对每一条 Tracing 自动化分析

- 分类统计当下故障服务情况,清晰定位造成延迟关键点。

- 聚合单个服务故障报告,聚焦重点问题。

智能化生成可解释的故障根因报告

-

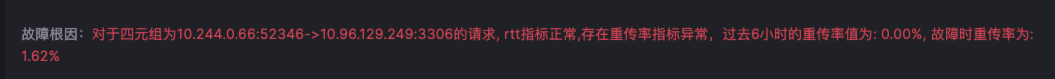

简明扼要给出可解释的根因报告,指明问题根因和方向。

-

报告包含 Trace 信息,描述、时间、耗时、TraceID等基本信息。

-

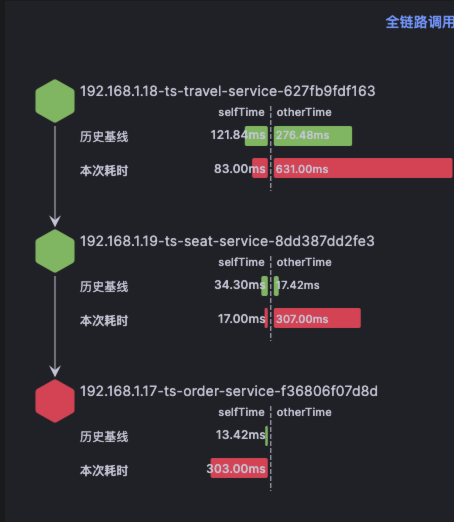

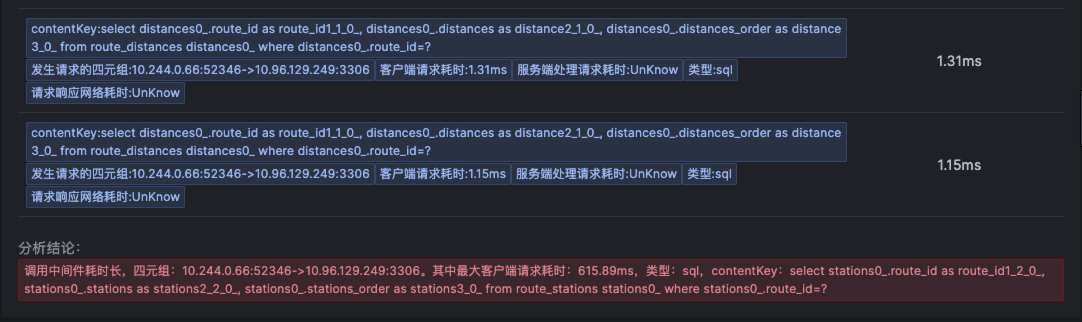

报告对节点链路调用情况及耗时数据进行详细对比分析。

-

提供节点详情、Trace 耗时情况对比及该时段对应日志。

-

提供各层级分段调用数据及单独的历史基线数据,对单次 Trace 耗时情况进行详细展示。

-

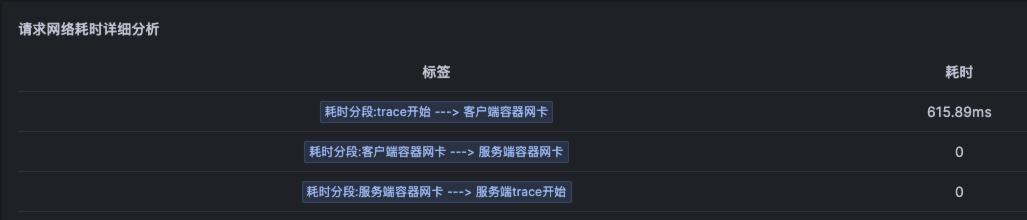

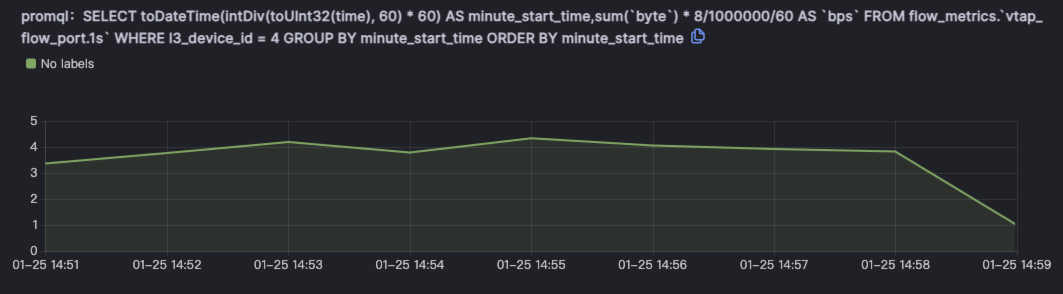

提供影响各条Trace数据的核心指标详情,帮助用户聚焦关键指标,并对关键指标数据进行下钻展示。例如本例判定故障根因由于网络导致,即会对网络调用数据进行下钻,并对更详细的数据进行分析展示。

-

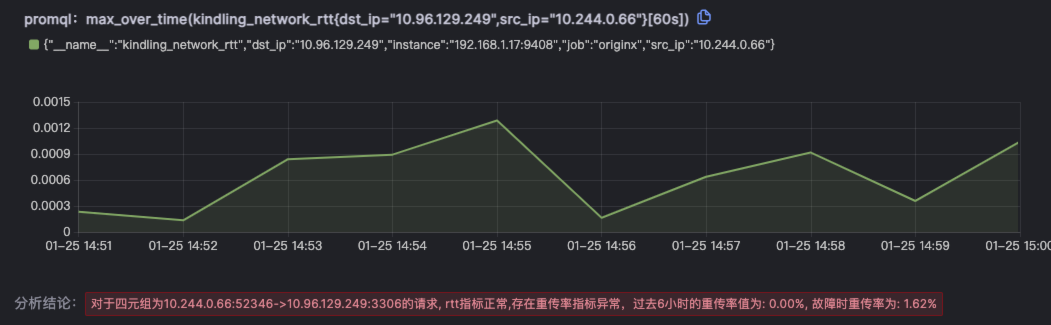

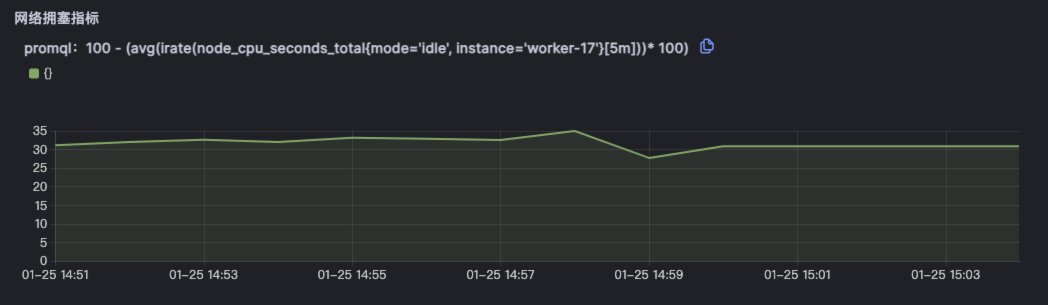

报告中包含根因推导过程的详细数据及指标,既可还原推导过程又可帮助还原现场。例如本例会对网络的相关各类指标均进行分析,用来最终确定具体根因。

Kindling-OriginX 相较于传统工具和方法,在定位和解决接口延迟问题上提供了更快速、更智能和更自动化的解决方案。

通过在线Demo)故障注入平台,注入例如 运行额外任务抢占Pod可用的CPU资源 Pod丢包30% 使方法抛出运行时异常 增加处理每个请求的CPU消耗 DNS请求延迟200ms 等故障来模拟真实环境中因各种因素导致的接口延迟问题。